はい!サウンド担当伊佐です。

私はラディアスリーのサウンド担当としてサウンド系のセッション(3日間で14セッション!!)に参加してきたわけですが、業界の動向とかハイエンドゲームのサウンド制作方法などなど、刺激を受けつつ自分が普段やっているスマホゲームの環境について考えさせられたところもあるので、備忘録もかねてブログに書いておこうかと思います。

今年のサウンド系セッションでキーワードになりそうなものを3つあげるとすれば・・・

みたいなところでしょうか?

ゲーム開発各社さんのセッションで共通の話題としてゲームにおける3D音響について語られる場面が多かったなぁ・・・というのが正直な感想です。

気になったキーワードは以下になります。

※説明があっているかはアヤシイので気になる方はググってくださいね。

チョー簡単に言うと、サラウンドスピーカーのパンニングアルゴリズムのことで、5.1ch サラウンドのように複数スピーカーの配置が前提の立体音響方のことをチャンネルベースとも言います。

素材音と音源位置や動きを分けて記録、伝達、再生する立体音響方式のことをオブジェクトベースといい、ゲームでは3D空間上のリスナーからの前後左右の方向と距離をリアルタイムで演算し、オブジェクトベースとして処理された音をチャンネルベース(5.1ch サラウンドとか 2ch ヘッドホン)に変換しているようです。

(スピーカーベースで考えられているので近接音が弱いらしいです)

めちゃくちゃ簡単に言うと、全天球カメラの音像表現として指向性マイクであらゆる方向の音を収録しておき、再生時にリスナーの首振りの角度に応じた方向の収録音を再生する方式のことでシーンベースという立体音響方式です。

最低限、前左右と後左右の 4ch の収録が必要で、収録する角度が多ければ多いほど定位感が増すらしいです。

(球体に64個?だかのマイクが仕込まれた試作マイクも写真で紹介されていました)

とてつもなく簡単に言うと、人間の頭部を模したダミーヘッドの耳の部分にマイクを仕込んで収録した音声のことで、目や鼻や耳たぶ自体を遮蔽物と考えて収録するため 2ch のステレオ再生、特にヘッドホンでの再生で非常にリアルに聞こえるのが特徴です。

(私も頭の周りをハエが飛ぶデモ音源を聞いたことがありますがメチャクチャリアルでした)

究極カンタンにいうと、頭部伝達関数といって人間の頭部(頭、耳、肩あたりまで)を遮蔽物として音の変化を伝達関数として表現したもので、実際に人間やダミーヘッドを使って HRTF を計測しておき、ゲームに応用するときにはオブジェクトベースの素材音に HRTF を畳み込み演算処理することで立体音響が表現できるという技術のようです。

(サウンドミドルウェアのプラグインとして HRTF のデモが参考出展されていましたが結構立体感ありました)

それぞれの方式に一長一短があり、業界的にもまだ探り中といった感じでしたね。

ヘッドホン環境では HRTF(に距離を加えたやつ)、局所で Binaural や Ambisonics。

スピーカー環境では相変わらずオブジェクトベース+チャンネルベース。

みたいな感じで現行は進む感じかな~と思います。

ゲーム開発各社さんのセッションでほとんどすべてのセッションで Audiokinetic Wwise のはなしが出てきていて、なんとなくコンシューマ系のビッグタイトルで導入が進んでいるような印象でした。

数年前に Wwise が出てきたときは英語環境しかなかったため敬遠していたのですが、今は日本法人も立てて本格的に参入してきているようです。

それまではサウンド系のミドルウェアといえばマルチプラットフォーム対応できるものは CRI ADX ぐらいしかなかったので隔世の感がありますね。

といったところでしょうか。

※もちろんそれ以外にもたくさん理由はありますが・・・

Wwise の利用例のセッションで気になったのは、多国語対応のビッグタイトルでボイスの収録数が10万行に達するようなことがあるそうなのですが、言語のタブを切り替えるだけで言語環境をチェンジでき、例えば日本語をベース言語に設定してファイルを追加していき、言語タブを切り替えて同じファイル名の英語音声を D&D して上書きするだけで各国語のフォルダに追加されていくのでプログラム側でサウンドのキューを変更することなく多国語対応できるという機能が紹介されていました。

また、Steinberg NUENDO8 のセッションで Wwise との連携機能を紹介していました。

スタジオでのボイス収録で NUEND8 のトラックに収録するファイル数分のブロックを一気に作成し、そのブロック名を一気に正規のファイル名にリネームし、ファイル書き出し用のマーカーを設定し、収録しつつ、修正しつつ、良きところで書き出しつつ、GameAudioCnnect2 という機能(NUENDO8 独自の機能)で Wwise に取り込むという、怒涛のような制作事例を紹介してくれました。

ショートセッション(25分)だったのですが、メチャクチャ効率の良い理想的なデモをしていて実はこのセッションがいちばんタメになったような気が・・・

コンシューマーのビッグタイトルでは大量のボイスを扱い、多言語対応をし、インタラクティブサウンドの対応もしなきゃならず、サウンドデザイナーがクリエイティブに避ける時間を捻出するためにも Wwise のようなミドルウェアを導入しているのかな~と感じました。

海外のボイス制作のスペシャリストの方がセッションしていたのですが、HALO や GearsOfWar など AAA タイトルでは8千~10万ワードのオーダーでのボイス制作が当たり前で、製作期間は3年費やすものもあるそうです。

例えば、ボイスアクターについてもユニオン(俳優組合)かノンユニオンから選択して(ユニオンとノンユニオンの共存は御法度らしいです)オーディションやセレブへのオファーが行われ、俳優のエージェントと契約を交わし、ボイスディレクターを選出し・・・と制作スタイルもハリウッドスタイルで行われているという話で、やっぱ規模が違うな~と。

ただ、ここでも Wwise が登場していて、予めシナリオがフィックスした段階で仮データ(容量見積もりもかねて実時間のファイルを作成します)でゲームビルドまで組んでしまって、スタジオでの収録時に録ったそばから Wwise に取り込んでゲームのビルドで確認をしながら納品データを作っていくというような使い方も紹介されていました。

このやり方は多言語対応する際、その国のスタジオ内で Wwise とゲームビルドで同じ作業、確認を行えばミスが防げるためとても有効な手段だと思います。

ほかにも「ニーア・オートマタ」の3Dオーディオ実現方法とか「ゼルダの伝説ブレスオブワイルド」の3Dフィールドにおける自然な環境音の配置とか、興味深いセッションがたくさんあったので、いずれ機会があれば書こうかな~と思います。

CEDEC に参加するのは実は初めてだったのですが、今回の CEDEC はサウンドのセッションが結構充実していたそうで、サウンド担当としては非常に有意義な3日間でした。

とまぁ、今回はこんなとこで。

次回は ADX2LE 試用レポートをやります。

ラディアスリー株式会社ではサウンド制作も行っております。

サウンド制作でお困りのアプリ開発者の皆様、お気軽にご相談くださいませ。

お問い合わせはコチラまで!

どもども~、サウンド担当の伊佐です。

「発注編」、「SE作成編」、「BGM作成編」に続いて

さてさて、なにをミックスする話なのかというと・・・ SE と BGM を同時に鳴らしてみること・・・即ちゲーム上で普通に行われていることを DAW 上で再現してみようゼ!と思ったわけです。

今回は BGM が鳴りつつ、複数の SE が同時再生されていくシーンを CubasePro9 の「サンプラートラック」という機能を利用してゲームのサウンド再生部分をシミュレートしてみます。

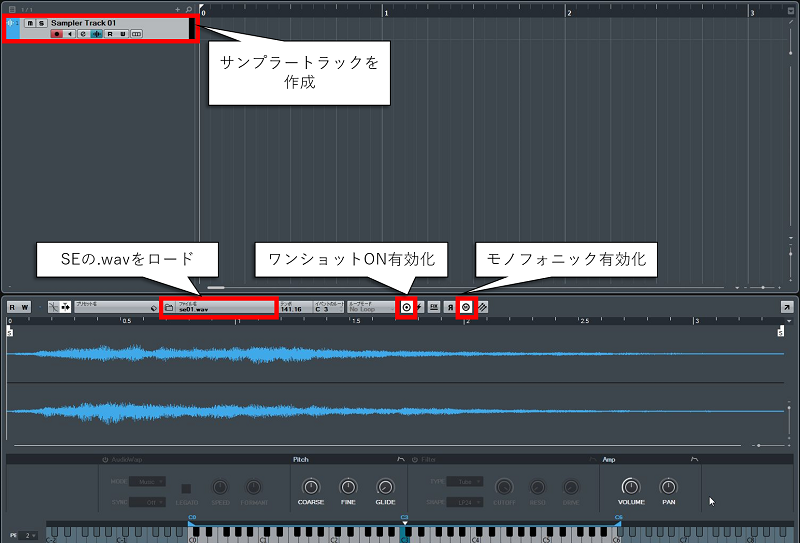

まずは CubasePro9 のメインウィンドウでサンプラートラックを作成します。

このサンプラートラックに作成済みの SE の .wav をロードします。

このとき、連続で発音する時に重複した音でピークを切らないように SE 自体はモノフォニック(単音)に設定します。

また、1度のコールで .wav の全体を鳴らしてほしいのでワンショットを ON にして有効化しておきます。

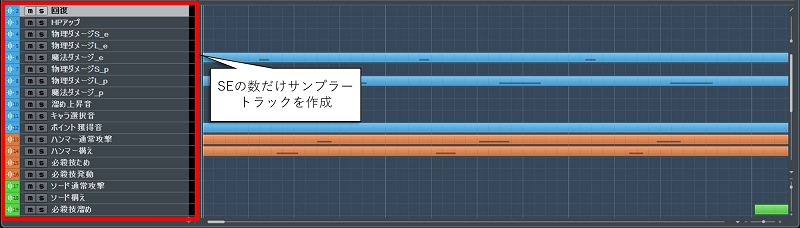

この作業を SE の数だけ繰り返して複数のサンプラートラックを用意します。

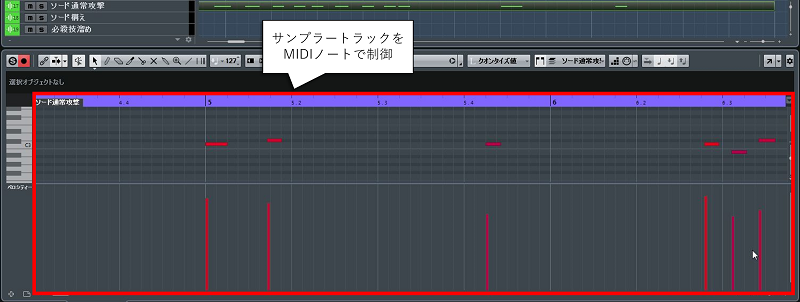

各サンプラートラックはプログラムのコールの代わりに MIDI ノートで制御を行います。

MIDI ノートを使う利点としてはベロシティで音量の大小、ノート No. でピッチの制御がやりやすいので実際の開発にもぜひ組み込んでほしいなと思う機能でもあります。

全てのサンプラートラックが用意できたので BGM を鳴らすためのオーディオトラックを作成し、BGM の .wav をインポートします。

これで SE と BGM が同時に再生できるようになったので、さっそく再生してみると BGM の音量が大きすぎて SE が聞き取りづらく、波形がピークを越えて音が割れたりと非常にバランスが悪いことが分かります。

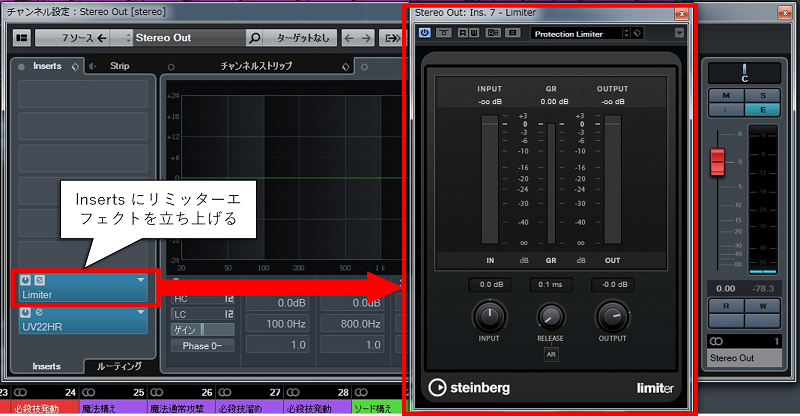

まずは BGM の音量を -6db 程度下げてあげて、手っ取り早くピークを切る問題を解決するために、最終段の Stereo Out にリミッターをかけてあげることにします。

下げすぎると聞こえないし、かといって下げないとピークを切るしで悩ましいところです。

ん~、確かにピークは切らなくなりましたが、ゴチャついた感じになってしまって聴感上あまり良くないですね。

こういう場合は SE が鳴ったと同時に BGM の音量が下がるような処理があれば良い訳ですが、そのたびに BGM トラックのボリュームカーブを操作するのは非常にメンドクサイ・・・。

また、ゲームの SE はユーザーの操作によって連続で再生されたり、複数で再生されたりするため波形のピークを切る瞬間が予測できません。

今回は DAW 上のシミュレートということではありますが、ちょっとズルをして MIX の技でこの問題を解決してみようと思います。

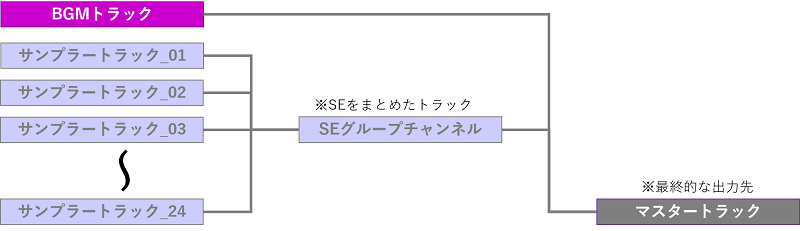

BGM が鳴りつつ SE を鳴らすという構図なので、まず SE の数だけ用意したサンプラートラックのアウトプットを1つのトラックにまとめていきます。

幸い CubasePro9 にはグループチャンネルという複数のアウトプットをまとめる機能があるのでこれを使っていきます。

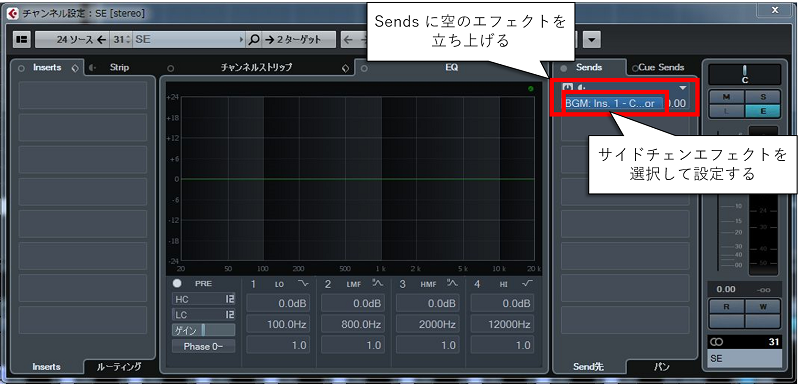

次に、SE が鳴った時に BGM を抑えたい訳ですから BGM トラックのインサートにコンプレッサー(音を抑えるエフェクト)を立ち上げます。

このとき、コンプレッサーのサイドチェインを ON にすることでサイドチェインに入力のあったときだけコンプレッサーを効かせることができるようになります。これをサイドチェインコンプと言ったりします。

今回の場合は SE トラックからの入力があった時だけ BGM トラックのサイドチェインコンプが掛かるようにしたいので SE トラックのセンドチャンネルに空のエフェクトを立ち上げてエフェクトの選択ペインで BGM トラックのインサートに立ち上がったサイドチェインエフェクトを選択してあげます。

さぁ、これで BGM 再生中に SE が複数再生されても BGM の音量が自動的に抑えられて SE が目立って聞こえるというMIXが完成しました。

今回もデモ音源を用意しましたのでどうぞ。

デモ音源ではチェインコンプのかかり具合が分かりやすいようにコンプのスレッショルドをかなり深めにしていますが、もっと自然にするならスレッショルドやアタック、リリースタイムを調整してあげれば良いでしょう。

実際のゲームの現場ではチェインコンプを使えるわけではありませんが、有償のサウンドミドルウェアなどでは「ボイスが鳴っているときにほかの音を下げる」という機能があるものもあることはあります。

本当はメーカーがデベロッパー向けに配布している SDK に標準でついててくれると助かるなぁとか思ったりするのですが、サウンドの機能は旧態依然としているのが現状のような気がします。

と、今回はこんなところで・・・

次回は CRI の ADX2LE のレポートでもやってみましょうか。

ラディアスリー株式会社ではサウンド制作も行っております。

サウンド制作でお困りのアプリ開発者の皆様、お気軽にご相談くださいませ。

お問い合わせはコチラまで!

ど~も~、サウンド担当の伊佐です。

「発注編」、「SE作成編」に続いて

さて、BGM、日本語に訳すとすれば「背景音楽」ですかね。

映画で言えば、アクションシーンや緊迫するシーンなど様々なシークエンスに、それを盛り上げるために挿入される音楽のことを指すかと思いますが、ゲームの場合も基本的にはシーンに合ったBGMを鳴らすという点において同義であると考えられます。

ゲームと映画で決定的に違うのは、そのシーンの尺が決まっているか、決まっていないかではないかと思います。

ゲームはユーザーの意思でそのシーンにどのぐらいの時間滞在するかが変化するものなので、そもそも尺の決まったBGMを作ることは構造上できないことになります。

ゲームの構造上BGMを再生する尺が決まらないわけですから、そのシーンが無音にならないためにBGMを繰り返し再生することになります。つなぎ目が分からないようにシームレスにループできるように作曲段階から考慮して作られているという特徴もありますね。(経験上、CDのリピート再生のように繰り返し時に少しでも間が開くとその瞬間に白けるという理由もあるかと思います)

ゲームと映画で決定的に違うことをもう1つあげるなら、映画はシーンが直列に繋がっており、しかも自動的に進むという形式なのですが、ゲームでは並列に並んだシーンをユーザーの自由意思によって選択していくものであるということです。(ドラ〇エでフィールドからなんチャラの城に行こうが××のほこらに行こうがユーザーの自由ってヤツです)

と、このようにゲームのBGMは一般に言うBGMとは違う性格を持っているわけですが、私が常に意識しているのが以下の考え方です。

例えば、タイトル画面30秒、ストーリー演出1分30秒、バトルシーン2分30秒などユーザーがどの程度そのシーンに滞在するか見当をつけてそれに見合った尺でしかもループできるように作曲をする。

これは純粋に労力を軽減する効果があります。

例えば、タイトル画面→セーブデータ選択画面→セーブ位置、みたいな場合を洗い出しておいて、それぞれの曲調がカブらないように作曲します。

似た曲調でもOKな場合は2曲作る必要がないと思うので事前に洗い出しておくことが1工程減らすことにつながります。

BGMはそのシーンでユーザーにこういう気持ちになってほしいという「記号」でもあるので、落ち着いている雰囲気を出したければテンポを落としてJAZZっぽいリズムにするとか、激しいバトルの雰囲気を出したければテンポを上げてROCKなリズムで攻めるなど・・・

これは雰囲気カブりを回避するうえでも有効です。

ストーリー演出画面→デッキ構築画面→バトルシーン、という流れで遷移してきた想定で、BPMは早すぎず遅すぎずの140に設定、4分打ちのキックで疾走感を出しつつ、ファンタジーっぽい世界観を崩さないためにメロディは美しいストリングスの音色で力強く、後半はあえてリズムを変えて少し膠着した緊張感を出し、最後はイントロのモチーフに回帰していくことでループしても違和感のないような構成になっています。

2分ぐらいでループしているのですがどこかわかりますか?

ということで、なんだかBGM制作のお話というよりもゲームBGM作成時のマインドセットのお話になりましたが、今回はここまで。

次回はBGMとSEを同時に鳴らした時のミックスについてのおはなしです。

ラディアスリー株式会社ではサウンド制作も行っております。

サウンド制作でお困りのアプリ開発者の皆様、お気軽にご相談くださいませ。

お問い合わせはコチラまで!

こんちは、サウンド担当の伊佐です。

「サウンドリスト」がきたし、絵コンテ等の資料もバッチリ揃った!

というところでいよいよSEを作成していきましょう。

私がBGMやSEを作成するときには基本的に全て、PCで完結するシステムを構成しています。具体的には、DAWである Steinberg CubasePro9 と Propellerhead Reason9、波形編集ソフトとして MAGIX SoundFrogePro11 を主に使用しています。

例えば、ライブラリから使えそうな音声をピックアップしてきても、そのままでは尺が長すぎたり、1部分だけ使いたい場合などは、ちょうど良い長さに編集したり、低域や高域がイメージに合わない場合はEQやエフェクトで調節したり、場合によってはそれを補完するような別の音を合成したりします。

前回提示した「サウンドリスト」のNo.23「魔法系キャラの必殺技を溜める音」を例にして、具体的にどのように作っているか紹介します。

上記の発注にはイメージとして「雷ゴロゴロ強風」という指定があるので「雷ゴロゴロ」と「強風」の2つの音を合成して作ってみたいと思います。

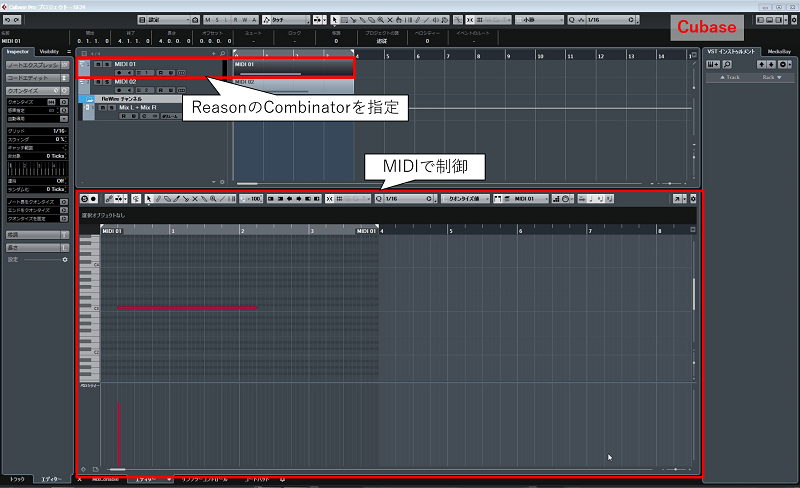

私がよくやるのが、CubasePro9 と Reason9 を ReWire で接続して連携させ Cubase をホストとして Reason をスレーブの音源として扱うようにセッティングして作成開始します。

まず、Reason で Combinator というユーティリティをマウントします。

これは複数のシンセやサンプラーを1つの楽器のように扱えるのでアイデア次第では非常に複雑で面白い音が作れるのが特徴の機能です。

さらに Combinator の中にミキサーとサンプラー2台をマウントします。

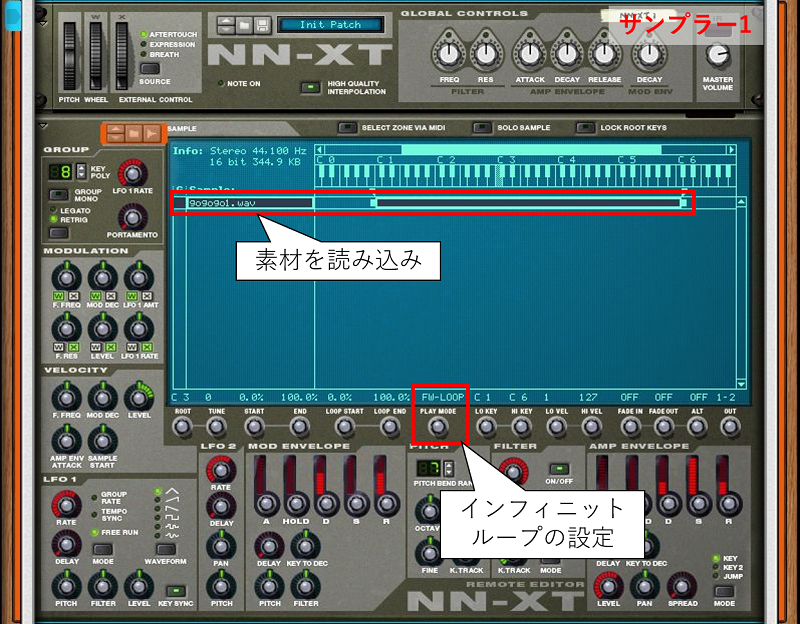

1台目のサンプラーには「雷が鳴る前のゴロゴロした音」をセットします。

このとき SoundFroge11 で、あらかじめループできるように波形編集しておき、サンプラーの再生方式をインフィニットループにすることで、鍵盤を押している間はずっと「雷がゴロゴロ」し続ける・・・という音色の完成です。

2代目のサンプラーには「嵐の強風の音」を、1台目と同様にインフィニットループできるようにセットしておきます。

あとはミキサーでそれぞれの音量やEQ、パンを調整し、エフェクト等で音質の調整を行えば音色の完成です。

最後に Cubase 側で Reason の Combinator を MIDI で制御できるようにセッティングすることで、鍵盤を押すと「雷が鳴る前のゴロゴロした音」と「嵐の強風の音」が合成されて鳴るという仕組みが完成します。

この仕組みができたら、絵コンテやムービー資料を見つつMIDI鍵盤でリアルタイムに弾いて最終のイメージに近づけていくのです。

このような手順を繰り返してオーダー分のSEをこさえていくのでございます。

ということで、前回の発注編で公開した「サウンドリスト」に従ってSE01~24まで作成したものをサウンドテスト風に再生するデモ音源を公開しますのでご拝聴くださいませ。

今回はここまで。

次回はBGM作成のおはなしです。

サウンド担当の伊佐と申します。

よろしくお願いします。

ゲーム体験において、グラフィクスやゲームシステムとともに非常に重要なファクターとして存在しているサウンド。

その「ゲームサウンド」について、これから何回かに分けてお話していこうかと思います。

昨今、スマホのゲームなどでは大手ゲームデベロッパーの作品以外ではサウンドは非常に軽視されている風潮が見られます。

なかには、サウンドがほとんどなくて「スマホをミュートしてたっけ?」と勘違いした作品すらあったぐらいです。

スマホゲームを開発しているような小さなゲームデベロッパーでは、iOSとAndroidをターゲットにしてUnity等のゲームエンジンで作成する場合が多いと思います。

iOSとAndroidの2種類作ればOKと思っていたのが、OSのバージョンや画面解像度、ビルド環境など、結構な数のマルチデバイス対応に追われることになり、グラフィクスや通信周りのプログラムに投資しているうちにリリースのデッドラインが近づいてサウンドにまで手が回らない。

というのが実情だったりするのではないでしょうか?

予算が少ないとか、開発期間が少ないとか、そもそも開発メンバーが少ないとか、いろいろあるのでしょうが・・・

ではどうすれば良いのか?

だったら「予算も期間もメンバーも増やせばよくね?」と思うかもしれませんが、それでは話が終わってしまうので、開発規模が小さくてもサウンドまで手が回る制作フローみたいなものを考えてみましょう。

ゲーム開発においてサウンドの発注はほとんどの場合「サウンドリスト」によって行われます。

プランナーもしくはディレクターから発注されることが多いですが、ようはゲーム全体を把握しているスタッフが、ゲームに必要なサウンドをリストアップしてサウンドの発注リストを作成することになります。

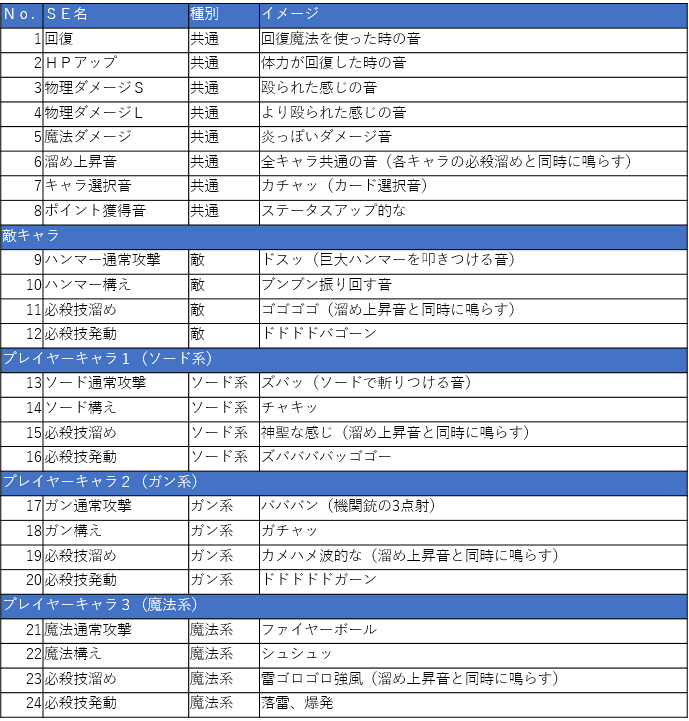

例として最近流行りのカードバトルゲームのバトルシーンの「サウンドリスト」を作成してみました。

最低限必要な情報はこのようなものでしょう。

あとはファイルフォーマットの指定で「 44.1khz 16bit の .wavファイルと.oggファイル mono でも stereo でも構いません。」みたいな1文があればOKです。

さぁ、出来上がった「サウンドリスト」をサウンド担当者に渡せば、ステキなサウンドが出来上がってくるまで待っていれば良い・・・というわけではありません。

従来、映画やアニメ等の映像制作の現場では「音入れ」といって編集済みの映像にBGMや効果音、アフレコを行ってようやく作品が出来上がるという、ポストプロセスに属する分野でも最後の工程と考えられています。

アフレコ作業時に絵がないということもあるそうですが、大抵は出来上がった映像に「音入れ」するわけです。

ゲームに置き換えてみるなら、絵も動きも出来上がった状態から音を作ることになりそうですが、お察しの通りゲーム開発の現場でそのような作りができることは奇跡に近いでしょう。

「サウンドリスト」にプラスして「ゲームフロー図」や「キャラ設定表」「絵コンテ」動きのわかる「ムービー」等、サウンド担当者が作業時にイメージしやすい資料を共有する・・・が正解です。

一見サウンドとは関係ないようにも思えますが、「絵」や「動き」や「演出」に対して音をつける訳ですから、もっとも重要な要素とも言えます。

つまり、ゲーム開発の作業フローを考えるなら、小規模な開発であっても上記のような資料を開発メンバーで共有することが「サウンドまで手が回る」開発の一助になると考えます。

特にサウンドを外注する場合は、期間や予算の関係から、イメージが合わないといって簡単にリテイクを出したりすることが難しいので、実は資料を作るというプリプロセスが大事だったりします。

今回はこの辺で・・・

次回は上記のサウンドリストを元に作成したデモ音源を交えつつ「SE作成」のお話です。